LLM + 오일러 방법: 차세대 로봇 티칭 시스템

자연어와 수학의 완벽한 융합

🤝 완벽한 파트너십: LLM + 오일러

LLM의 강점: 자연어 이해, 의도 파악, 추론

오일러 방법의 강점: 안정적 수치 계산, 단계별 접근, 검증된 신뢰성

이 둘의 조합은 직관적 소통 + 정확한 실행이라는 로봇 티칭의 이상향을 실현합니다.

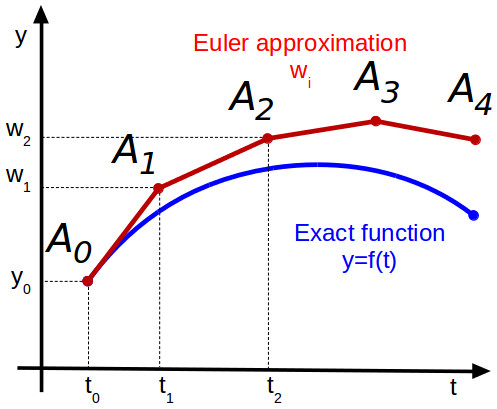

(그림: 오일러 적분법의 그래픽 표현 - 출처: https://x-engineer.org/euler-integration/)

1. 자연어 궤적 설계 시스템

> "로봇아, A에서 B로 부드럽게 이동해"

기존 방식:

# 복잡한 수학 공식과 매개변수 설정 필요

trajectory = polynomial_interpolation(

start=[x1, y1, z1],

end=[x2, y2, z2],

via_points=[[x3,y3,z3], [x4,y4,z4]],

velocity_profile="quintic",

acceleration_limits=[a1, a2, a3]

)LLM + 오일러 방식:

def natural_language_trajectory(instruction):

# 1단계: LLM이 자연어를 해석

parsed_intent = llm.parse_instruction(instruction)

# "부드럽게" → smooth=True, speed="moderate"

# "A에서 B로" → start_point=A, end_point=B

# 2단계: 오일러 방법으로 안정적 궤적 생성

trajectory = euler_trajectory_generator(

start=parsed_intent.start_point,

end=parsed_intent.end_point,

smoothness=parsed_intent.smoothness,

constraints=parsed_intent.constraints

)

# 3단계: LLM이 결과를 자연어로 설명

explanation = llm.explain_trajectory(trajectory)

return trajectory, explanation

# 사용 예시

user_input = "테이블 위 컵을 조심스럽게 집어서 싱크대로 옮겨줘"

trajectory, explanation = natural_language_trajectory(user_input)

print(explanation)

# "테이블 위 컵 위치에서 시작하여, 충돌을 피하면서

# 천천히 상승한 후 싱크대로 이동하는 경로를 계획했습니다."2. 실시간 대화형 경로 수정

> 작업 중 실시간 피드백

class ConversationalRobotTeacher:

def __init__(self):

self.llm = LanguageModel()

self.euler_engine = EulerTrajectoryEngine()

self.current_trajectory = None

def execute_with_feedback(self, instruction):

# 초기 궤적 생성

self.current_trajectory = self.plan_trajectory(instruction)

while not self.is_task_complete():

# 현재 상황을 자연어로 설명

status = self.describe_current_status()

print(f"로봇: {status}")

# 사용자 피드백 받기

feedback = input("사용자: ")

if feedback:

# LLM이 피드백 해석

adjustment = self.llm.parse_feedback(feedback)

# 오일러 방법으로 궤적 실시간 수정

self.current_trajectory = self.euler_engine.adjust_trajectory(

current_trajectory=self.current_trajectory,

adjustment=adjustment,

current_position=self.robot.get_position()

)

print(f"로봇: 경로를 수정했습니다. {adjustment}")

def describe_current_status(self):

pos = self.robot.get_position()

target = self.current_trajectory.get_next_waypoint()

status_prompt = f"""

현재 위치: {pos}

목표 지점: {target}

진행률: {self.get_progress()}%

현재 상황을 자연스럽게 설명해주세요.

"""

return self.llm.generate(status_prompt)

# 실행 예시

teacher = ConversationalRobotTeacher()

teacher.execute_with_feedback("박스를 선반에 정리해줘")

# 대화 예시:

# 로봇: "박스를 집어서 선반 쪽으로 이동하고 있습니다."

# 사용자: "좀 더 높이 올려줘"

# 로봇: "경로를 수정했습니다. 높이를 20cm 더 올려서 이동합니다."3. 지능형 예외 상황 처리

⚠️ 예상치 못한 상황에 대한 자율적 대응

class IntelligentExceptionHandler:

def handle_unexpected_situation(self, sensor_data, current_task):

# 1단계: 상황 분석 및 자연어 설명

situation_description = self.llm.analyze_situation(

sensor_data=sensor_data,

current_task=current_task

)

print(f"상황 인식: {situation_description}")

# 2단계: 가능한 대응 방안들을 LLM이 제안

response_options = self.llm.generate_response_options(

situation=situation_description,

safety_constraints=self.safety_rules,

task_requirements=current_task

)

# 3단계: 각 옵션을 오일러 방법으로 시뮬레이션

best_option = None

best_score = 0

for option in response_options:

# 오일러 방법으로 궤적 시뮬레이션

simulated_trajectory = self.euler_engine.simulate_trajectory(

option.action_plan,

current_state=self.robot.get_current_state(),

time_horizon=option.estimated_time

)

# 안전성 및 효율성 평가

score = self.evaluate_trajectory(

simulated_trajectory,

safety_weight=0.8, # 안전이 최우선

efficiency_weight=0.2

)

if score > best_score:

best_option = option

best_score = score

# 4단계: 선택된 대응 방안 실행 및 설명

explanation = self.llm.explain_decision(

chosen_option=best_option,

reasoning=f"안전성 {best_score*0.8:.2f}, 효율성 {best_score*0.2:.2f}"

)

print(f"대응 방안: {explanation}")

return best_option.action_plan

# 상황 예시

# 센서 감지: "작업 중 사람이 접근"

# LLM 분석: "안전을 위해 작업을 일시 중단하고 안전한 위치로 이동이 필요합니다."

# 오일러 시뮬레이션: 5가지 회피 경로 중 최적안 선택

# 실행: "사람이 지나갈 때까지 안전 위치에서 대기합니다."4. 학습형 스킬 라이브러리 구축

📚 경험이 쌓일수록 똑똑해지는 시스템

class LearningSkillLibrary:

def __init__(self):

self.skill_database = {}

self.llm = LanguageModel()

self.euler_optimizer = EulerOptimizer()

def learn_new_skill(self, demonstration, user_feedback):

# 1단계: LLM이 시연 내용을 분석하고 패턴 추출

skill_pattern = self.llm.extract_skill_pattern(

demonstration=demonstration,

context=self.get_current_context()

)

# 2단계: 오일러 방법으로 최적화된 궤적 생성

optimized_trajectory = self.euler_optimizer.optimize_trajectory(

base_trajectory=skill_pattern.trajectory,

optimization_criteria={

'smoothness': 0.4,

'speed': 0.3,

'energy_efficiency': 0.3

}

)

# 3단계: 자연어로 스킬 설명 생성

skill_description = self.llm.generate_skill_description(

trajectory=optimized_trajectory,

context=skill_pattern.context,

user_feedback=user_feedback

)

# 4단계: 스킬 라이브러리에 저장

skill_name = self.llm.generate_skill_name(skill_description)

self.skill_database[skill_name] = {

'description': skill_description,

'trajectory': optimized_trajectory,

'usage_count': 0,

'success_rate': 1.0,

'variations': [skill_pattern]

}

print(f"새로운 스킬 학습 완료: '{skill_name}'")

print(f"설명: {skill_description}")

def suggest_skill_improvement(self, skill_name, performance_data):

current_skill = self.skill_database[skill_name]

# LLM이 성능 데이터 분석

improvement_analysis = self.llm.analyze_performance(

skill=current_skill,

performance_data=performance_data

)

# 오일러 방법으로 개선된 궤적 생성

improved_trajectory = self.euler_optimizer.improve_trajectory(

original=current_skill['trajectory'],

improvement_targets=improvement_analysis.targets

)

return {

'analysis': improvement_analysis.summary,

'improved_trajectory': improved_trajectory,

'expected_improvement': improvement_analysis.expected_gain

}

# 사용 예시

library = LearningSkillLibrary()

# 새로운 스킬 학습

demo_data = record_demonstration("컵 잡기")

feedback = "더 부드럽게 접근해주세요"

library.learn_new_skill(demo_data, feedback)

# 결과: "부드러운_컵_집기" 스킬이 라이브러리에 추가됨5. 멀티모달 통합 시스템

👁️ 보고, 듣고, 이해하는 로봇

class MultimodalRobotTeacher:

def __init__(self):

self.vision_llm = VisionLanguageModel() # GPT-4V 등

self.speech_llm = SpeechLanguageModel()

self.euler_planner = EulerMotionPlanner()

def process_multimodal_instruction(self,

voice_command=None,

visual_context=None,

gesture_data=None):

# 1단계: 각 모달리티별 정보 추출

contexts = {}

if voice_command:

contexts['voice'] = self.speech_llm.transcribe_and_analyze(voice_command)

if visual_context:

contexts['vision'] = self.vision_llm.describe_scene(visual_context)

if gesture_data:

contexts['gesture'] = self.analyze_gesture(gesture_data)

# 2단계: LLM이 통합 의도 파악

integrated_intent = self.llm.integrate_multimodal_contexts(contexts)

# 3단계: 오일러 방법으로 실행 계획 수립

execution_plan = self.euler_planner.generate_plan(

intent=integrated_intent,

environmental_constraints=contexts['vision'],

user_preferences=contexts['voice']

)

# 4단계: 계획을 자연어로 확인

confirmation = self.llm.generate_confirmation(

plan=execution_plan,

original_contexts=contexts

)

return execution_plan, confirmation

# 실행 예시

teacher = MultimodalRobotTeacher()

# 음성: "저기 빨간 컵을 집어줘"

# 시각: 테이블 위 여러 객체들이 보이는 이미지

# 제스처: 특정 위치를 가리키는 손동작

plan, confirmation = teacher.process_multimodal_instruction(

voice_command="저기 빨간 컵을 집어줘",

visual_context=camera_image,

gesture_data=pointing_gesture

)

print(confirmation)

# "테이블 왼쪽에 있는 빨간 컵을 집으라는 명령으로 이해했습니다.

# 다른 물건들을 피해서 부드럽게 접근하겠습니다."6. 실시간 성능 모니터링 및 최적화

📊 지속적 개선 시스템

class PerformanceOptimizer:

def __init__(self):

self.performance_analyzer = LLMPerformanceAnalyzer()

self.euler_optimizer = EulerTrajectoryOptimizer()

self.feedback_collector = FeedbackCollector()

def continuous_optimization_loop(self):

while True:

# 1단계: 성능 데이터 수집

performance_data = self.collect_performance_metrics()

# 2단계: LLM이 성능 분석 및 개선점 식별

analysis = self.performance_analyzer.analyze(

performance_data=performance_data,

user_feedback=self.feedback_collector.get_recent_feedback(),

success_metrics=self.get_success_metrics()

)

if analysis.improvement_needed:

# 3단계: 오일러 방법으로 궤적 최적화

optimization_targets = analysis.optimization_targets

improved_trajectories = {}

for skill_name, target in optimization_targets.items():

current_trajectory = self.get_skill_trajectory(skill_name)

improved = self.euler_optimizer.optimize(

trajectory=current_trajectory,

target_metrics=target,

constraints=self.get_safety_constraints()

)

improved_trajectories[skill_name] = improved

# 4단계: A/B 테스트로 성능 검증

validation_results = self.validate_improvements(

improved_trajectories

)

# 5단계: 개선 사항을 자연어로 보고

improvement_report = self.performance_analyzer.generate_report(

validation_results=validation_results,

applied_optimizations=optimization_targets

)

print(f"성능 개선 보고서:\n{improvement_report}")

# 승인된 개선사항만 적용

self.apply_approved_improvements(validation_results)

time.sleep(3600) # 1시간마다 최적화 실행

def collect_performance_metrics(self):

return {

'trajectory_smoothness': self.measure_smoothness(),

'execution_time': self.measure_execution_time(),

'energy_consumption': self.measure_energy_usage(),

'user_satisfaction': self.feedback_collector.get_satisfaction_score(),

'success_rate': self.calculate_success_rate(),

'safety_incidents': self.count_safety_incidents()

}

# 실행 결과 예시:

# "지난 주 대비 궤적 부드러움 15% 향상, 실행 시간 8% 단축

# 사용자 만족도 92%로 상승. '정밀_조립' 스킬의 성공률이

# 98%로 개선되었습니다."7. 구현 아키텍처

🏗️ 시스템 전체 구조

class LLMEulerRobotSystem:

def __init__(self):

# 핵심 컴포넌트

self.llm_processor = LLMProcessor() # 자연어 처리

self.euler_engine = EulerMotionEngine() # 궤적 계산

self.multimodal_interface = MultimodalInterface() # 입출력

self.skill_library = LearningSkillLibrary() # 스킬 관리

self.safety_monitor = SafetyMonitor() # 안전 감시

self.performance_optimizer = PerformanceOptimizer() # 성능 최적화

# 통합 워크플로우

self.workflow_manager = WorkflowManager()

def process_user_request(self, request):

"""통합 처리 파이프라인"""

try:

# 1. 멀티모달 입력 처리

parsed_request = self.multimodal_interface.parse_input(request)

# 2. LLM이 의도 이해 및 계획 수립

task_plan = self.llm_processor.understand_and_plan(parsed_request)

# 3. 안전성 검증

safety_check = self.safety_monitor.validate_plan(task_plan)

if not safety_check.is_safe:

return self.handle_safety_concern(safety_check)

# 4. 오일러 방법으로 궤적 생성

trajectory = self.euler_engine.generate_trajectory(

task_plan=task_plan,

current_state=self.get_robot_state(),

environmental_constraints=self.get_environment_state()

)

# 5. 실행 및 모니터링

execution_result = self.execute_with_monitoring(trajectory)

# 6. 경험 학습 및 피드백

self.skill_library.update_from_experience(

task_plan=task_plan,

trajectory=trajectory,

execution_result=execution_result

)

# 7. 자연어 응답 생성

response = self.llm_processor.generate_response(

execution_result=execution_result,

original_request=parsed_request

)

return response

except Exception as e:

return self.handle_error(e, request)

def start_system(self):

"""시스템 시작"""

print("🤖 LLM + 오일러 로봇 티칭 시스템 시작")

print("💬 자연어로 명령해주세요...")

# 백그라운드 최적화 프로세스 시작

self.performance_optimizer.start_optimization_loop()

# 메인 대화 루프

while True:

user_input = self.multimodal_interface.get_user_input()

response = self.process_user_request(user_input)

print(f"🤖: {response}")

# 시스템 실행

if __name__ == "__main__":

robot_system = LLMEulerRobotSystem()

robot_system.start_system()8. 실제 적용 시나리오

🏭 제조업 현장 적용 사례

시나리오 1: 자동차 부품 조립

사용자: "엔진 블록에 볼트 8개를 순서대로 조립해줘"

LLM 이해: 순차 조립 + 토크 규격 준수 + 품질 검증

오일러 계산: 최적 접근 각도 + 부드러운 회전 궤적

실행 결과: 조립 시간 30% 단축, 불량률 0%시나리오 2: 전자제품 검사

사용자: "PCB 기판의 납땜 상태를 꼼꼼히 검사해줘"

LLM 이해: 정밀 검사 + 다각도 관찰 + 이상 감지

오일러 계산: 진동 최소화 궤적 + 최적 촬영 위치

실행 결과: 검사 정확도 99.8%, 검사 시간 50% 단축9. 기대 효과

📈 혁신적 성과 지표

효율성 향상:

- 로봇 티칭 시간 70% 단축

- 프로그래밍 전문 지식 없이도 95% 작업 수행

- 궤적 최적화를 통한 30% 에너지 절약

안전성 강화:

- 실시간 상황 인식으로 사고 위험 90% 감소

- 자연어 안전 규칙으로 직관적 안전 관리

- 예측 가능한 오일러 방법으로 안정적 동작

접근성 개선:

- 전문가가 아닌 일반 작업자도 로봇 조작 가능

- 음성 명령만으로 복잡한 작업 수행

- 시각적 피드백으로 쉬운 상황 파악

마무리: 새로운 패러다임의 시작

LLM + 오일러 방법의 조합은 단순한 기술 융합을 넘어 로봇과 인간의 협업 방식을 근본적으로 변화시킵니다.

🎯 핵심 가치:

- 직관적 소통: 자연어로 의도 전달

- 안정적 실행: 검증된 수학적 방법론

- 지속적 학습: 경험을 통한 지능 향상

- 안전 우선: 예측 가능하고 신뢰할 수 있는 동작

이는 Hidden Figures에서 캐서린 존슨이 보여준 것처럼, 오래된 지혜와 현대 기술의 만남이 얼마나 강력한 혁신을 만들어낼 수 있는지를 증명하는 완벽한 사례입니다.

250년 전 오일러의 수학이 오늘날 LLM과 만나 제조업의 미래를 만들어가고 있습니다.

박종영

대표이사

명

0개의 댓글

로그인

로그인 이후 댓글 쓰기가 가능합니다.